词是“最小的能独立运用的语言单位”。中文与英文文本有很大的不同,对英文而言,一个单词就是一个词,由空格隔开;而汉语是以字为基本的书写单位,一个词由一个或多个汉字组成,词语之间没有明显的区分标记,需要人为切分。汉语在分词中也没有统一的构词标准,因此中文自动分词比英文复杂得多。中文自动分词是利用计算机对中文文本进行词语自动识别的过程,是中文信息处理的一个重要组成部分,在中文文本的自动检索、过滤、分类及摘要,中文文本的自动校对,汉外机器翻译,汉字识别与汉语语音识别的后处理,汉语语音合成等领域中都扮演着极为重要的角色。对于中文自动分词的研究已经取得了很多成果,出现了众多的算法。根据其特点,可以将现有的分词算法分为三大类:基于规则的分词方法、基于统计的分词方法和基于机器学习的分词方法等。

基于规则的分词方法又称基于字符串匹配的分词方法、基于字典的分词方法等,它是按照一定的策略将待分词的汉字串与一个“充分大的”机器词典中的词条进行匹配。 若在词典中找到某个字符串,则匹配成功(识别出一个词)。典型的方法有最大匹配法(MM)、最大逆向匹配法(RMM)、最佳匹配法等。基于规则的分词方法算法简单、易于实现,且分词一致性好,但是也存在巨大的局限性。第一,过于依赖词典和规则,受词典领域限制,几乎无法解决未登录词问题,缺乏自学习的智能性;第二,词典构建工作量大,且词本身没有一个标准的定义,没有统一标准的词集;第三,存在交集型和组合型歧义切分问题,不同词典产生的歧义也不同。

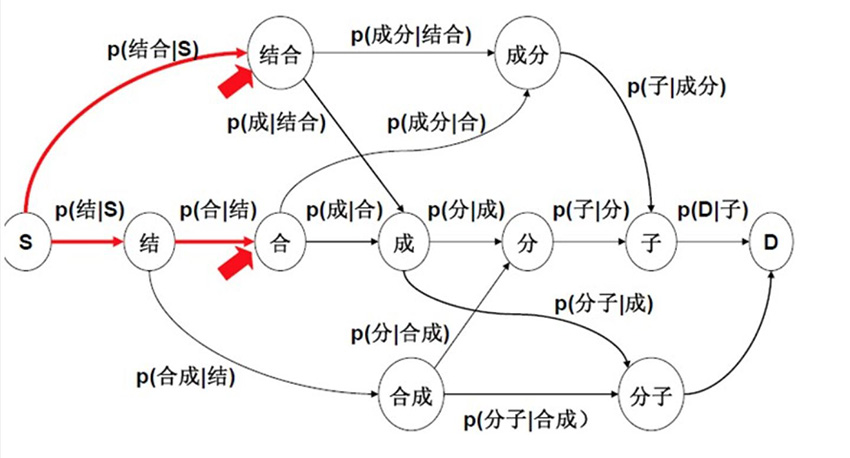

随着数学和概率对中文自动分词的影响,基于统计的分词方法逐渐成为主流。该方法的主要思想:词是稳定的组合,因此在上下文中,相邻的字同时出现的次数越多,就越有可能构成一个词。因此字与字相邻出现的概率或频率能较好反映成词的可信度。可以对训练文本中相邻出现的各个字的组合的频度进行统计,计算它们之间的互现信息。互现信息体现了汉字之间结合关系的紧密程度。当紧密程度高于某一个阈值时,便可以认为此字组可能构成了一个词。典型的方法有隐马尔可夫模型、最大熵模型等。基于统计的分词算法不需要构建词典,不受待处理文本的领域限制,能够有效地自动排除歧义,能够一定程度上识别新词。但是该方法需要大量的训练文本,计算量较大。

基于机器学习的分词方法与基于统计的分词方法均是依赖训练语料库的方法。典型的方法有条件随机场、长短时记忆网络等。基于机器学习的分词方法智能性强,能较好地适应不断变化的语言现象,对新词的识别效果好,且分词正确率高。但是,基于机器学习的自动分词算法往往比较复杂,对硬件具有较高要求;分词过程对于研究者来说是一个“黑箱”,结果可解释性较差。

参考文献:

[1] 张启宇,朱玲,张雅萍.中文分词算法研究综述[J].情报探索,2008(11):53-56.

[2] 奉国和,郑伟.国内中文自动分词技术研究综述[J].图书情报工作,2011,55(02):41-45.

原文出处:http://corpus.njau.edu.cn/wiki/wiki/004

相关文章阅读

几个常见的汉语语料库分析

互联网上开放的中文语料库有哪些

新时代人民日报分词模型